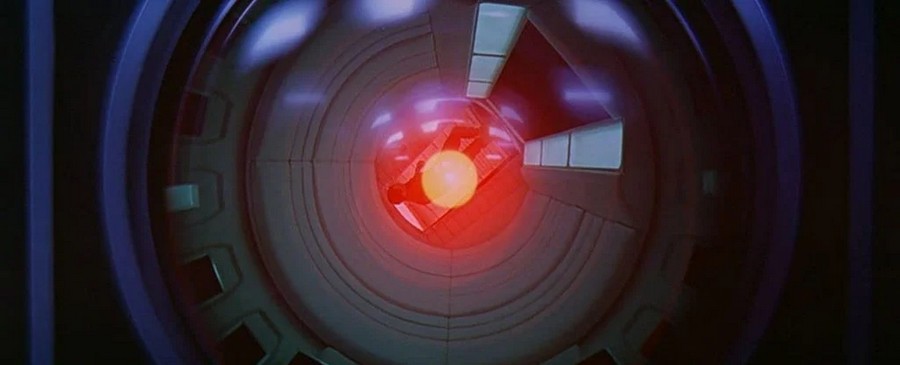

人工智能推翻人类的想法已经争论了几十年,2021 年 月,科学家们就我们是否可以控制高级计算机超级智能做出了裁决。 回答? 几乎可以肯定不是。

问题在于,要控制一个远超人类理解范围的超级思维,需要对我们可以分析的超级思维进行模拟。 但如果我们无法理解它,就不可能创建这样的模拟。

一篇 2021 年论文的作者认为,除非我们了解人工智能 (AI) 会提出什么场景,否则无法建立诸如“不伤害人类”之类的规则。 一旦计算机系统的工作水平超出我们程序员的能力,我们将无法再设置限制。

研究人员写道:“超级智能是一个与通常打着‘机器人伦理学’旗号研究的问题根本不同的问题。” “这是因为超级头脑是多方面的,因此有可能调动各种资源来实现人类可能难以理解的目标,更不用说可控了。”

团队的部分推理来自 停工问题,由艾伦·图灵于 1936 年提出。 挑战在于弄清楚计算机程序是否会得出结论并回答(并停止),或者只是永远徘徊以试图找到答案。

正如图灵在帮助下证明的那样 智能数学,虽然我们可能知道某些特定程序的这一点,但逻辑上不可能找到一种方法让我们知道可能编写的每个潜在程序的这一点。 这让我们回到人工智能,处于超级智能状态的人工智能可以同时将所有可能的计算机程序存储在它的内存中。

也很有趣:

例如,任何为阻止 AI 伤害人类和毁灭世界而编写的程序可能会或可能不会得出结论(并停止)——无论哪种方式在数学上都不可能绝对确定,这意味着它无法被限制。 “这基本上使威慑算法无法使用,”德国马克斯普朗克人类发展研究所的计算机科学家 Iyad Rahwan 在 月份表示。

研究人员表示,除了教授 AI 伦理和禁止毁灭世界的禁令之外,没有任何算法可以绝对确定这一点,另一种选择是限制超级思维的能力。 例如,它可能会与部分 Internet 或某些网络断开连接。

最近一项研究的作者也拒绝了这个想法,认为它会限制人工智能的范围 - 他们说,如果我们不打算用它来解决超出人类能力的问题,那么为什么要创造它呢?

如果我们要推进人工智能,我们可能甚至不知道什么时候会出现一个超级智能,我们无法控制,深不可测。 这意味着我们需要开始就我们的前进方向提出严肃的问题。

“运行世界的超级智能机器听起来像科幻小说,”马克斯普朗克人类发展研究所的计算机科学家 Manuel Kebrian 说。 但是已经有机器可以独立执行一些重要的任务,而程序员并不完全理解他们是如何学会这些的。

这就是问题出现的原因,它是否会在某个时候变得无法控制并对人类造成危险......

另请阅读: